L’etica dell’algoritmo

L’Intelligenza artificiale è influenzata dalla cultura e dai valori di chi la sviluppa, così come la selezione dei dati, la definizione degli obiettivi e le decisioni relative all

L’Intelligenza artificiale è influenzata dalla cultura e dai valori di chi la sviluppa, così come la selezione dei dati, la definizione degli obiettivi e le decisioni relative alla progettazione e all’implementazione degli algoritmi, sono frutto di decisioni prese da esseri umani. Ciò significa che il procedimento può essere condizionato da pregiudizi, stereotipi culturali, discriminazioni. Come utenti è bene saperlo, con l’auspicio di un approccio inclusivo da parte di chi progetta e implementa i sistemi di AI

La notizia è arrivata tra fine marzo e inizio aprile a sorpresa: il Garante della Privacy ha bloccato l’accesso a ChatGPT dall’Italia. Fake news. Il blocco di accesso ad un sito web è un provvedimento che un’autorità amministrativa non può prendere. Quello che è realmente successo, invece, è stata la limitazione provvisoria del trattamento dei dati degli utenti italiani nei confronti di OpenAI, predisposto fino al pieno rispetto della normativa europea (Regolamento Ue 2016/679). ChatGPT ha dunque deciso in qualche modo di “autosospendersi” in Italia. Tre le questioni fondamentali evidenziate dal Garante: l’assenza di qualunque informativa agli utenti e agli interessati i cui dati sono stati raccolti da OpenAI e trattati tramite il servizio di ChatGPT; l’assenza di idonea base giuridica in relazione alla raccolta dei dati personali e al loro trattamento per scopo di addestramento degli algoritmi sottesi al funzionamento di ChatGPT; l’assenza di qualsivoglia verifica dell’età degli utenti in relazione al servizio ChatGPT. Le questioni toccate dal Garante sono effettivamente nodali, dal momento che i dati di addestramento utilizzati per creare questo specifico modello di linguaggio sono stati raccolti da una varietà di fonti, come libri, articoli di giornale, conversazioni online e altro ancora. È possibile accedere a queste fonti? Come sappiamo che sono sicure? I dati di addestramento utilizzati per creare ChatGPT provengono principalmente da fonti pubbliche, come ad esempio i sopracitati libri, articoli di giornale e altri testi disponibili online. Il processo di raccolta dei dati e la loro origine non sono però sotto il controllo di ChatGPT o del team di sviluppo che ha creato il modello. Di conseguenza, non è possibile essere certi che tutti i dati di addestramento siano sicuri o privi di errori o di contenuti inappropriati.

Inoltre, il team di sviluppo di ChatGPT utilizza una varietà di modelli di apprendimento automatico avanzati per migliorare l’addestramento del modello e la qualità delle conversazioni generate. Questi modelli includono tecniche di elaborazione del linguaggio naturale, reti neurali artificiali, algoritmi di apprendimento supervisionato e non supervisionato e altro ancora. Non va però dimenticato che l’Intelligenza artificiale (AI) è influenzata dalla cultura e dai valori di chi la sviluppa. L’AI è il risultato dell’elaborazione di dati e informazioni da parte di algoritmi e modelli matematici, ma la selezione dei dati, la definizione degli obiettivi e le decisioni relative alla progettazione e all’implementazione degli algoritmi, sono prese da esseri umani. Pertanto, le scelte che vengono fatte durante il processo di sviluppo dell’AI possono essere influenzate dalle convinzioni culturali e dai valori di chi le fa.

Ciò significa che l’Intelligenza artificiale può essere condizionata da pregiudizi e stereotipi culturali, come il razzismo, il sessismo e altre forme di discriminazione. Per evitare che ciò accada, è necessario adottare un approccio etico e sensibile alla diversità nella progettazione e nell’implementazione dei sistemi AI. Inoltre, la mancanza di forme di tutele specifiche verso i soggetti vulnerabili, ed in particolare i minori, rende la questione particolarmente delicata sotto il profilo del safeguarding (misure volte a proteggere la salute, il benessere e i diritti umani delle persone), oggi considerato via maestra per evitare ogni forma di abuso.

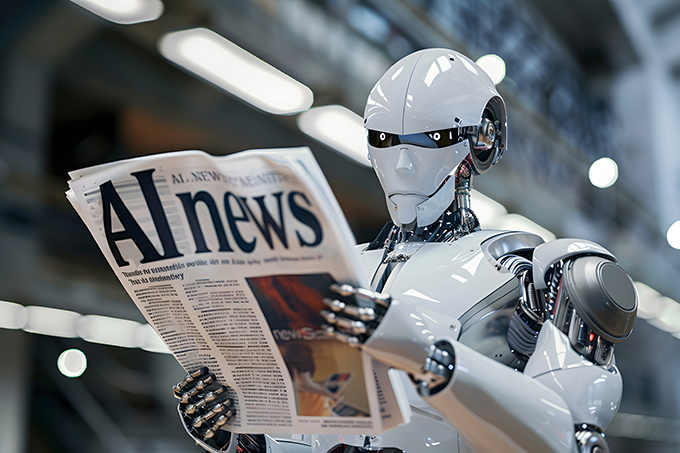

Uno dei più gravi rischi connessi a ChatGPT e a qualunque forma di linguaggio fondato sull’AI è quello di costruire etero narrazioni false e fuorvianti, che possono avere gravi conseguenze sotto il profilo delle relazioni personali

In mancanza di un controllo effettivo sul trattamento e sulla correttezza dei dati di addestramento, così come di norme etiche chiare, capaci di evitare ogni forma di discriminazione, il rischio principale dei modelli di linguaggio fondati sull’Intelligenza artificiale è quello di creare gravi pericoli per il rispetto dell’identità personale. Autorevolmente definita come “una cornucopia in cui si tutelano la dignità, il credo religioso, le opinioni politiche e sindacali, l’etnia, il sesso e l’orientamento sessuale, la lingua, la disabilità, le origini genetiche” (Alpa), l’identità personale rappresenta oggi per il giurista “il modo di essere della persona” (Del Prato), l’insieme dei caratteri e dei connotati che differenziano un soggetto dall’altro e che, nello stesso tempo, ne costituiscono l’essenza unica e irripetibile. Si tratta di un insieme di peculiarità che hanno una dimensione anagrafica, biologica, sociale, psichica, relazionale, affettiva: alcune di esse sono immutabili e connesse al patrimonio genetico, altre vengono imposte dal contesto familiare o sociale e possono essere mutate solo con una certa complessità e dopo una presa di coscienza. Altre ancora, soprattutto entro la sfera psichica e relazionale, sono frutto di uno sviluppo dei propri sentimenti e del proprio modo di intendere la vita e la realtà, della risposta alle grandi domande di senso, del proprio vissuto personale e professionale. La giurisprudenza, anche su sollecitazione delle considerazioni di autorevole dottrina, ha spesso enfatizzato come il diritto all’identità personale si realizza, in primo luogo, nell’interesse a vedersi rappresentati all’interno della relazione sociale in modo corretto: interesse alla “corretta rappresentazione sociale della personalità” dell’individuo (Trucco), “specificamente, nell’interesse a che la proiezione della propria personalità non venga travisata tramite l’attribuzione non veritiera di determinati fatti o qualità” (De Cupis).

In questa prospettiva, il diritto all’identità costituisce prima di tutto un limite all’etero narrazione relativa ad un determinato individuo: nel senso che qualunque soggetto che si trovi a rappresentare quell’individuo è obbligato a tratteggiarne un’immagine corrispondente alla sua vera identità, senza possibilità di modificare, offuscare o comunque alterare il “patrimonio intellettuale, ideologico, etico, professionale quale già estrinsecatosi o destinato, comunque, ad estrinsecarsi, nell’ambiente sociale, secondo indici di previsione costituiti da circostanze obiettive ed univoche” (Cassazione 978/1996). Ecco, uno dei più gravi rischi connessi a ChatGPT e a qualunque forma di linguaggio fondato sull’AI è quello di costruire etero narrazioni false e fuorvianti, che possono avere gravi conseguenze sotto il profilo delle relazioni personali, dei rapporti professionali e financo nella dimensione più intima delle caratteristiche personali connesse al principio di uguaglianza e al pieno godimento dei fondamentali diritti di libertà.

Dida immagine realizzata da Lisa Aramini Frei con Midjourney: “La rappresentazione che ChatGPT ha di se stesso”